Pourquoi l'IA symbolique ne suffit-elle pas ?

5 min de lecture

Dans notre article précédent, nous nous interrogions sur la confiance donnée aux Intelligences Artificielles. Nous évoquions dans une première partie l’IA connexionniste et ses limites. Aujourd’hui, ce second article étudie les spécificités de l’IA symbolique au travers du Traitement Automatique des Langues Naturelles (TALN) ou Natural Language Processing (NLP) en anglais. Comme vous allez le voir, l’IA symbolique satisfait les attentes en matière de confiance pour un système d’IA. Mais alors, pourquoi l’IA symbolique ne suffit-elle pas ? Avant de répondre à cette question, reprenons d’abord la genèse de ce sujet.

La Génèse

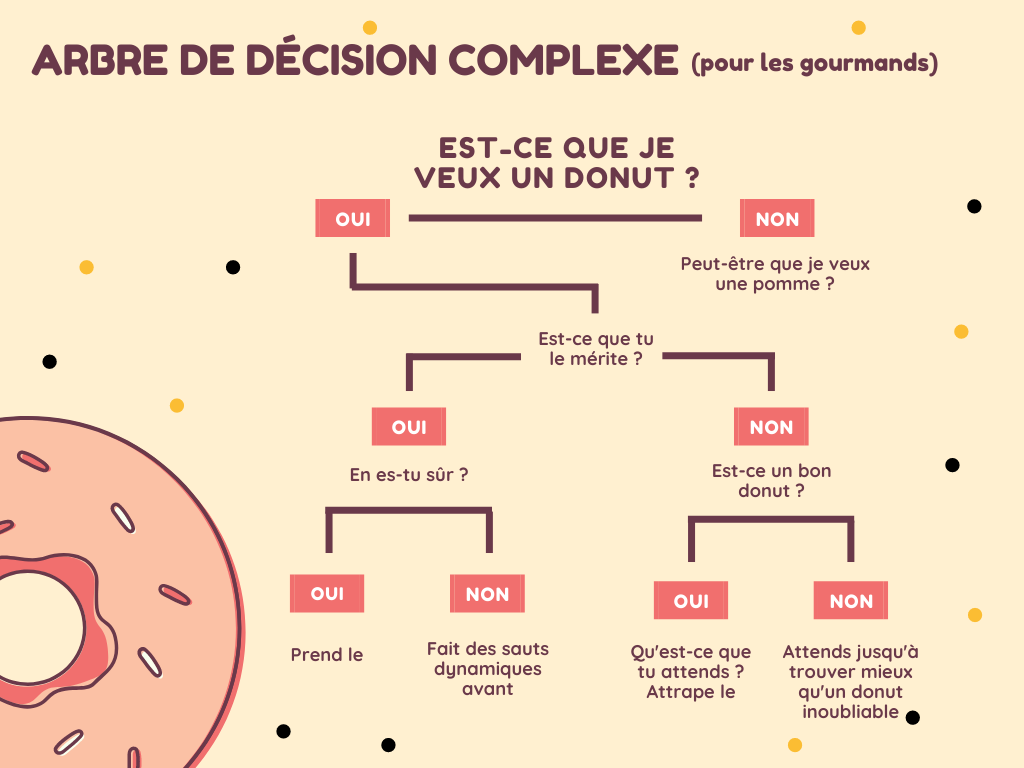

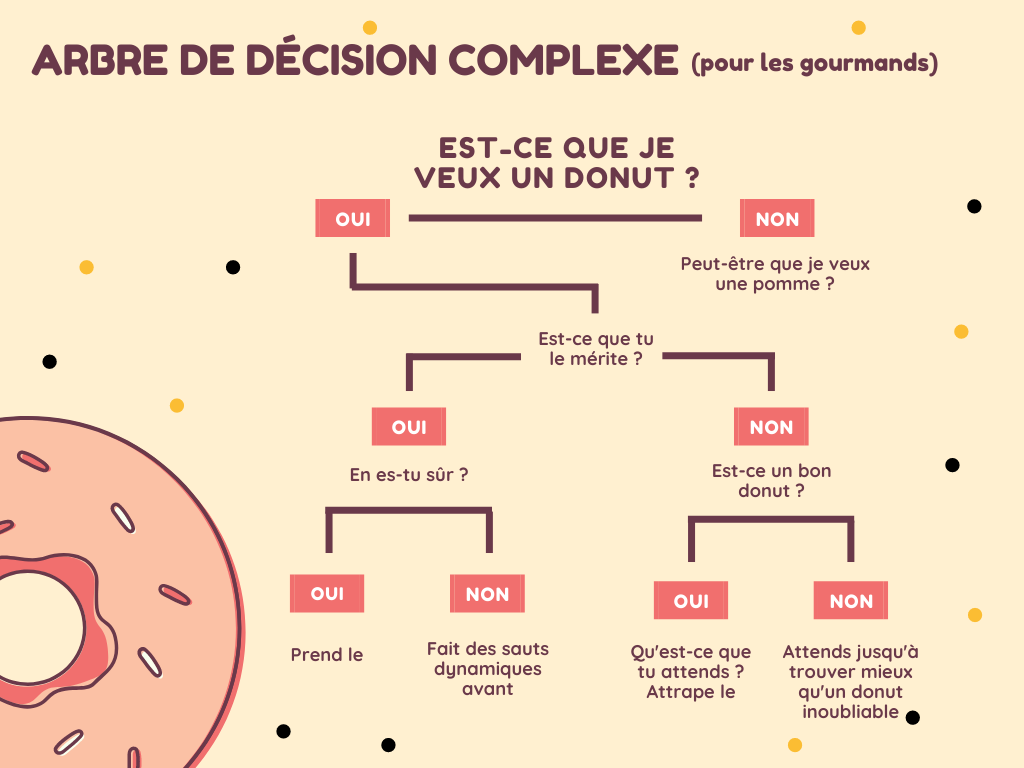

L’IA symbolique repose sur des règles construites par les humains. Ainsi, ils guident les différentes étapes de traitement jusqu’au résultat. Il est souvent représentés par un arbre de décisions plus ou moins complexe.

Cette construction exploite la représentation explicite de connaissances, ce qui permet de faciliter sa compréhension par l’Homme et son implémentation sous forme d’algorithmes.

Application en NLP

L’IA symbolique peut être appliquée à de nombreuses disciplines, dont le NLP. À l’origine, dans les années 50, le domaine militaire investit principalement dans le développement de l’IA linguistique permettant la fouille de documents soviétiques.

Plus généralement, l’objectif de cette technologie est de permettre aux machines de déchiffrer et donner du sens au langage humain. Pour atteindre ce résultat, il faut apprendre à une machine à manipuler le langage humain. Mais comment automatiquement encoder ce langage ? La compréhension du langage n’est pas fondée uniquement sur un ensemble de critères logiques d’évaluation. Elle est aussi le résultat émergeant de processus cognitifs qu’on ne sait pas toujours décrire de façon algorithmique. Mais alors, comment prédéfinir une architecture qui permettrait à ces divers niveaux de connaissances de collaborer harmonieusement ?

Théorie linguistique

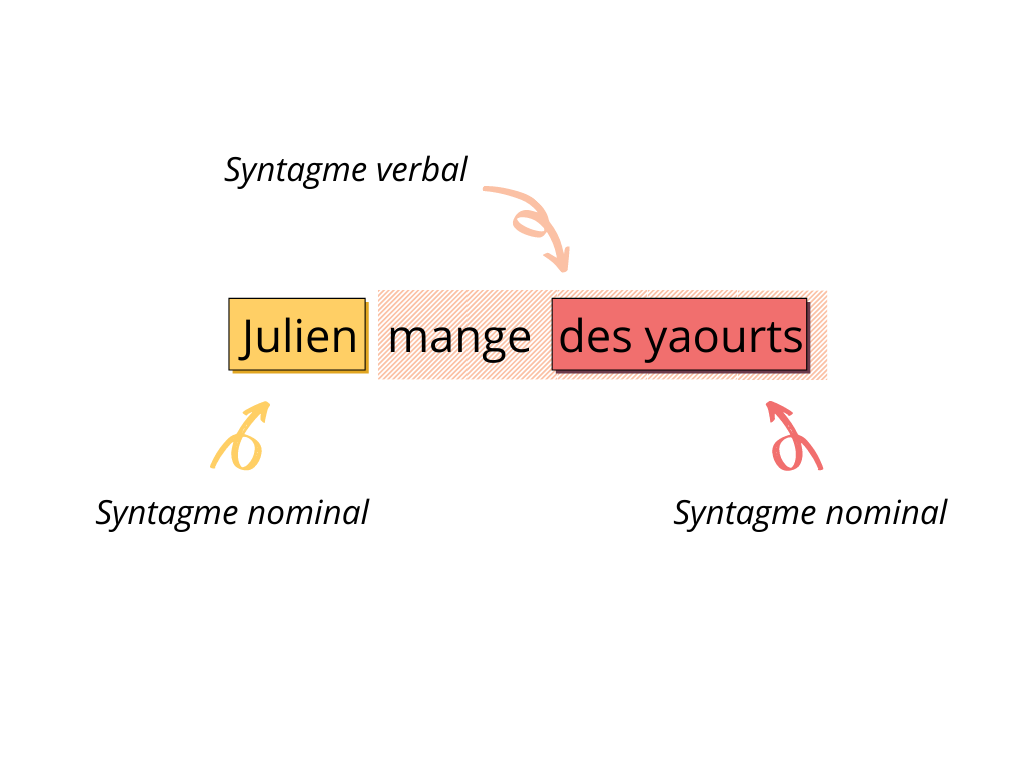

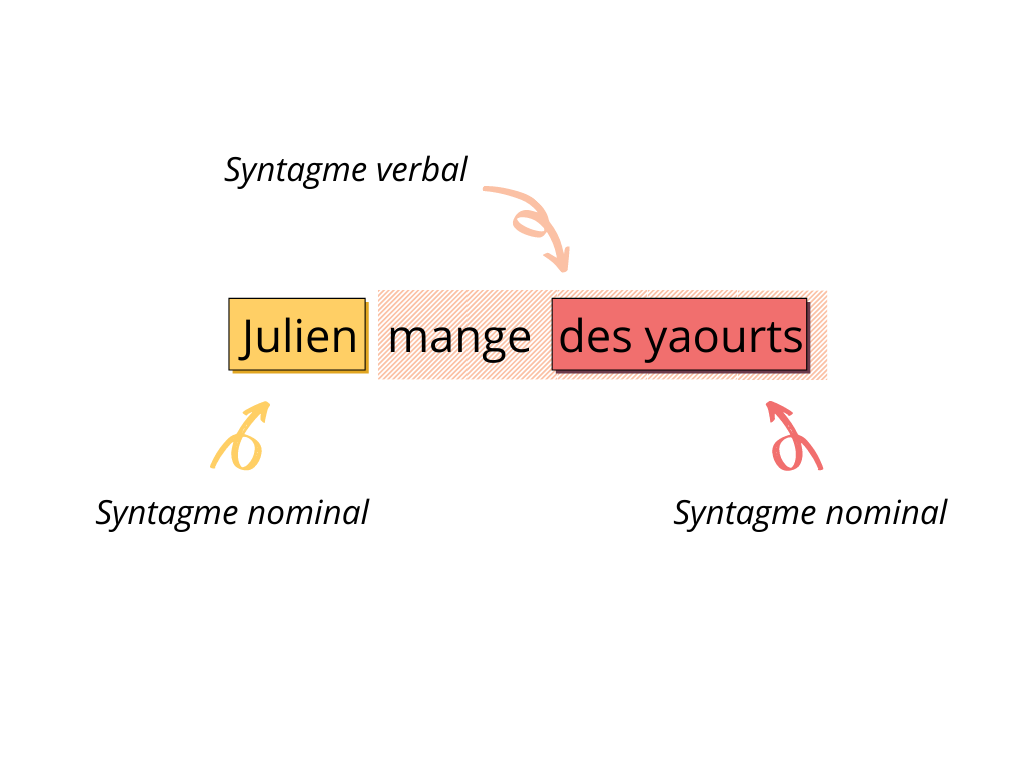

Dans les années 50, une théorie linguistique émerge : la théorie des grammaires génératives et transformationnelles (GGT), décrite par Noam Chomsky. Cette théorie évoque le fait que les humains naissent avec une conception syntaxique universelle et qu’il leur reste à acquérir le vocabulaire. La formalisation de cette théorie consiste à définir chaque élément syntaxique d’un énoncé par les éléments syntaxiques qui la composent, comme l’illustre l’exemple suivant.

Exemple

Cet énoncé, syntaxiquement typique en français, permet de formaliser la règle suivante :

Phrase = “syntagme nominal” + “syntagme verbal”

Chaque syntagme peut lui-même être découpé en unités de plus bas niveau :

Syntagme nominal = “nom propre”, “déterminant + nom commun”, “déterminant + adjectif + nom commun”, etc.

Syntagme verbal = “verbe (intransitif)”, “verbe (transitif direct) + syntagme nominal”, “verbe (transitif indirect) + syntagme prépositionnel”, etc.

Quand suffisamment d’énoncés ont été étudiés, il devient possible de formaliser les structures les plus fréquentes d’une langue donnée.

L’exemple le plus connu de cette théorie met en avant la distinction fondamentale entre analyse syntaxique et analyse sémantique : “D’incolores idées vertes dorment furieusement.”

Si cet énoncé est syntaxiquement valide, il est sémantiquement ininterprétable.

Cependant, depuis les années 60 de nombreux travaux ont été menés pour automatiser le traitement du langage naturel. Dans un premier temps sous l’angle de la logique formelle. Ces recherches ont notamment permis de voir émerger une nouvelle approche de langages formels : les moteurs d’inférence, dont l’emblématique Prolog (acronyme de PROgrammation en LOGique), pionnier des systèmes experts appliqués à l’analyse automatique du langage naturel.

Prolog

Sans en être le descendant direct, Prolog mobilise des mécanismes similaires à la grammaire générative. Il s’appuie notamment sur les structures syntaxiques. Cependant, cette technologie propose un niveau de sophistication supplémentaire en faisant appel à des ressources linguistiques pour appréhender certains aspects sémantiques du langage naturel.

Il devient dès lors possible de détecter automatiquement dans un texte les phrases respectant ou non une structure pré-définie ainsi qu’un certain niveau de cohérence sémantique.

Inconvénients

L’IA symbolique, malgré son efficience évidente et sa transparence, comporte des limites. S’il est vrai qu’on obtient des résultats assez rapidement et toujours explicables, cette approche ne peut fonctionner que sur des cas anticipés. Concrètement, cela signifie que le système mis en œuvre pourra fournir des résultats uniquement sur les phénomènes à la fois connus par les experts de la tâche à accomplir et déclarés formellement selon l’approche choisie.

Certaines méthodes permettent de ne pas échouer à la première variation rencontrée, mais la multiplication des règles augmente la complexité des algorithmes. Ce qui allonge les temps de calculs jusqu’à les rendre inacceptables pour des usages dans le réel.

Perspectives

Comme nous l’avons exposé dans le billet précédent, les limites de l’IA symbolique en matière de performance ont été contournées par les approches connexionnistes. Tout l’enjeu est aujourd’hui de bénéficier du meilleur des deux approches : un système performant ET explicable !

Notre prochain article sur ce sujet vous présentera les pistes que le NLP explore de nos jours pour répondre à ces attentes, alors suivez-nous pour savoir quoi répondre si on vous demande si “IA” et “explicabilité” sont compatibles.

Autres articles

Pouvons-nous faire confiance aux décisions prises par l’Intelligence Artificielle ? (1/3)

L’Intelligence Artificielle apparaît comme le nouvel enjeu technologique incontournable dans lequel un grand nombre...

Pouvons-nous faire confiance aux décisions prises par l’Intelligence Artificielle ? (2/3)

Comme vous allez le voir, l’IA symbolique satisfait les attentes en matière de confiance pour un système d’IA....