IA de confiance, où en est-on aujourd'hui ?

5 min de lecture

Rappel

Nous vous avons présenté dans les articles précédents, deux familles majoritaires d’IA : symbolique et connexionniste. En prenant l’exemple du NLP, cela nous a permis d’évoquer les différentes facettes de ces IA. Et ainsi, comprendre comment le NLP a trouvé des applications s’appuyant sur chacune d’entre elle, en fonction des époques, des besoins et des contraintes.

Aujourd’hui, ces méthodes prennent une place imposante dans notre quotidien. Et donc, soulève la question de la confiance, qui passe par l’explicabilité des résultats.

Piste 1 : combiner les deux

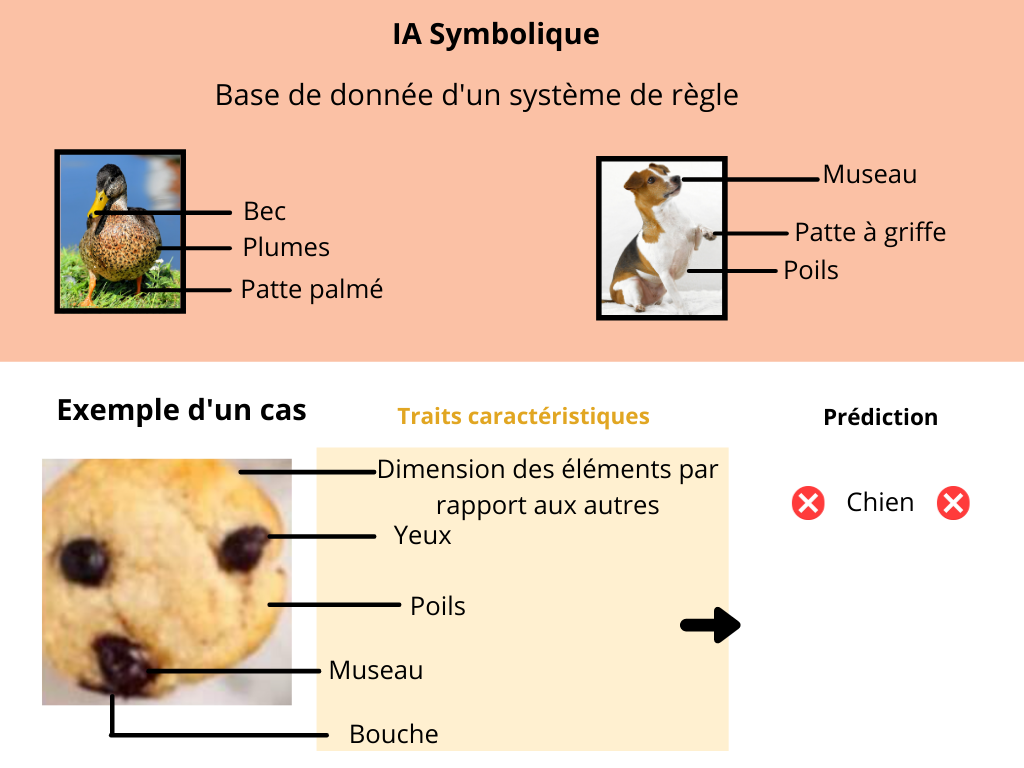

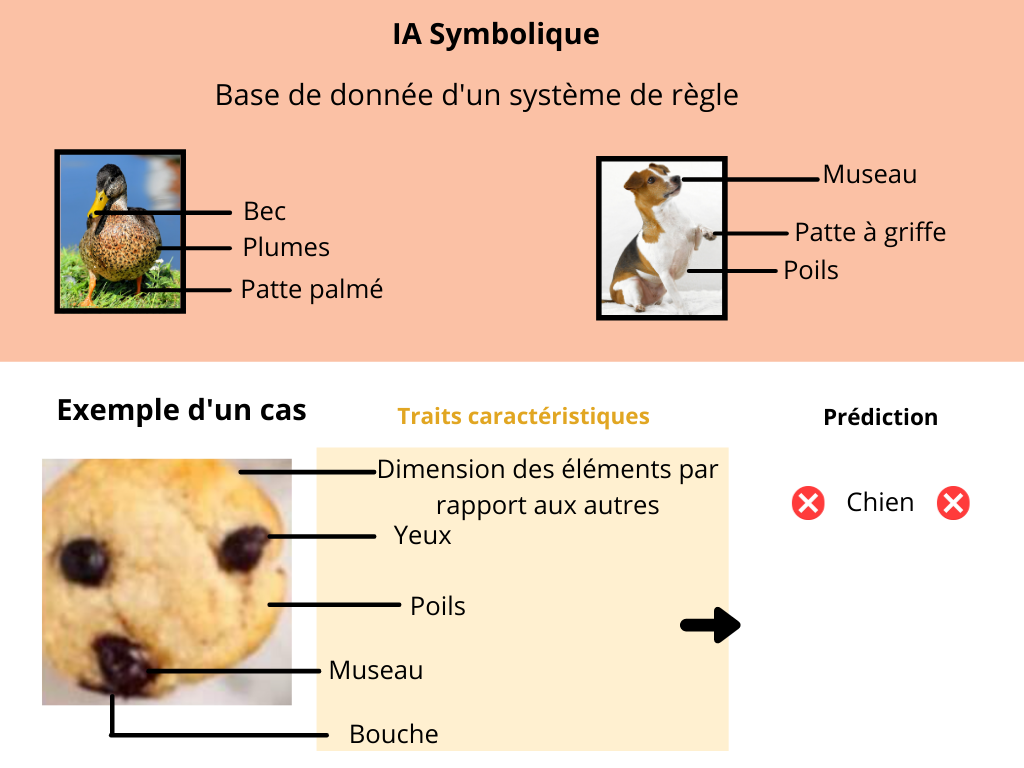

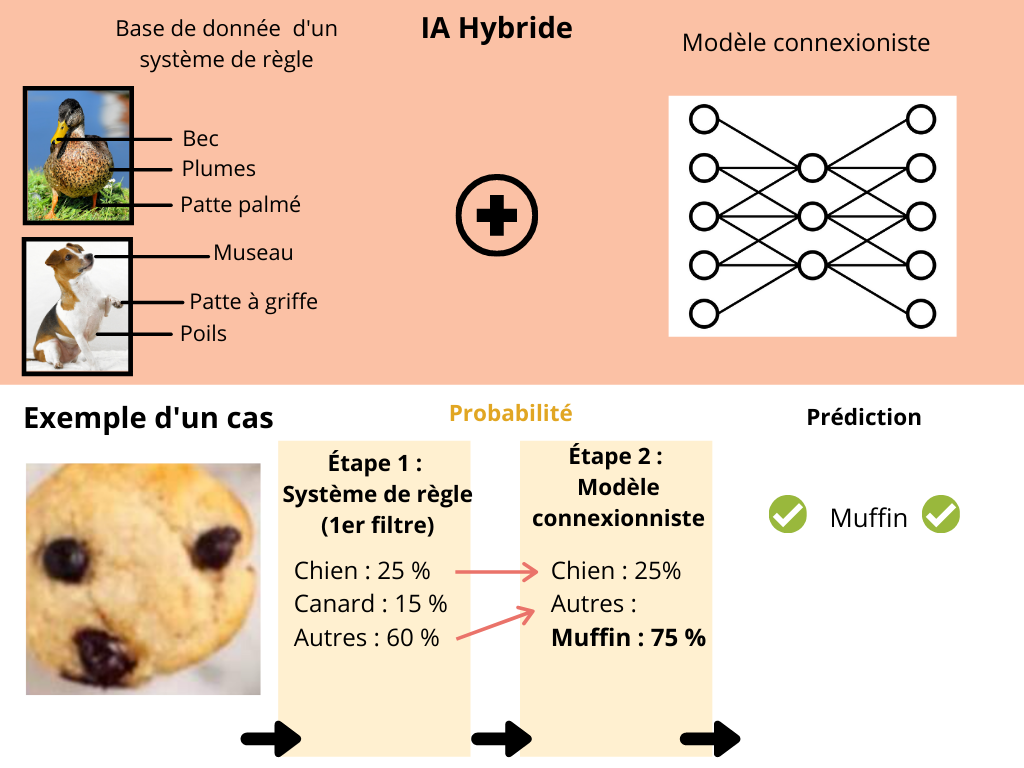

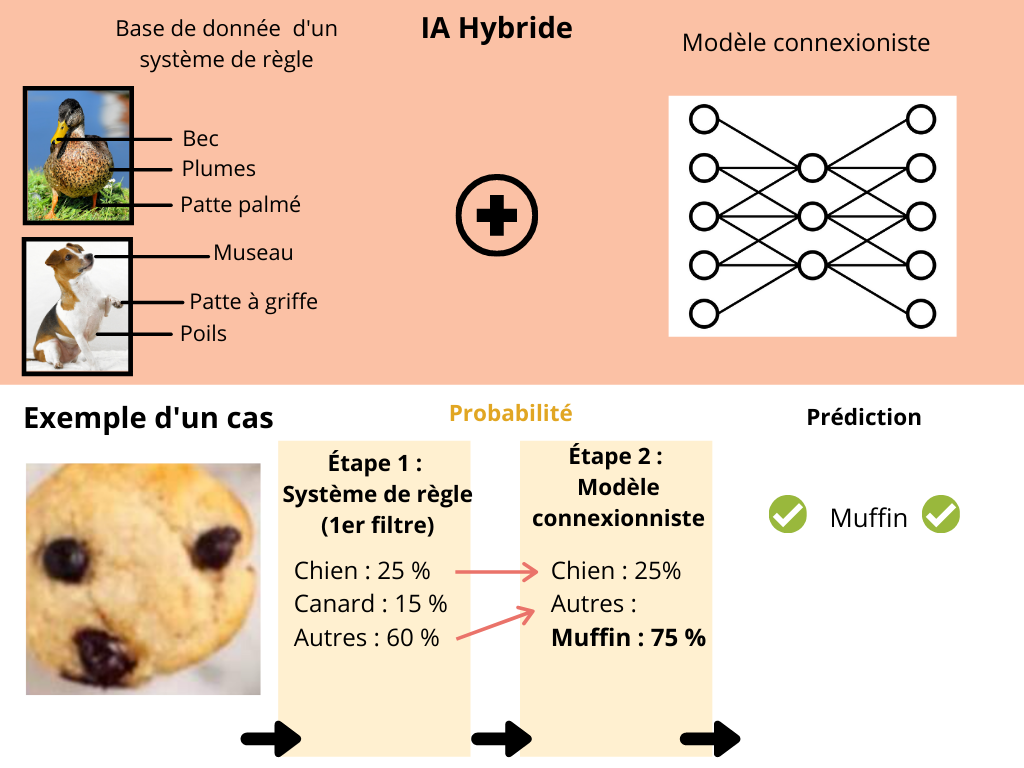

De plus en plus de systèmes modernes cherchent à associer des approches symboliques (constituées de règles formelles, codées par des experts des actions à mener). Mais aussi des approches connexionnistes (modèles qui reposent sur l’apprentissage automatique à partir de données d’exemples).

S’il est quasiment impossible de l’illustrer sans rentrer dans des considérations techniques poussées, on peut imaginer un exemple simplifié : la construction d’un système expert assistée par un système par apprentissage automatique.

Concrètement, ça consiste à présenter un modèle connexionniste intermédiaire, dont les premières règles sont déclarées par un expert sous forme de données d’entraînement.

Cette méthode permet d’accélérer l’enrichissement de la base de données initiale sans démultiplier les efforts humains. Nous pourrions également optimiser la déclaration de certaines règles. À la suite des phénomènes détectés par la machine grâce à une abstraction différentes des concepts manipulés. Cette base de données, toujours composée de règles explicites directement évaluables par des opérateurs, maintient un très haut degré d’explicabilité. C’est cette explicabilité qui généralisera la confiance accordée aux résultats obtenus grâce au système expert.

Ce type de système peut sembler idéal mais c’est encore une solution coûteuse et complexe à mettre en place.

Piste 2 : identifier les facteurs déterminants

Une autre perspective concerne la possibilité de prouver que les résultats ne sont pas aléatoires. Ainsi, il est possible de déduire, dans une certaine mesure, quels facteurs ont influencé des choix.

Par exemple, dans le cas de l’analyse de sentiments appliquée à un verbatim d’avis de consommateurs, on peut en tirer un résultat global comme l’illustre le diagramme suivant.

Pouvoir afficher la liste des avis associés à l’une de ces réponses donne un premier niveau d’explicabilité des résultats : à la lecture on se rendra rapidement compte s’il y a un écart important entre l’étiquette donnée par le système et celle que l’on aurait donnée. C’est justement quand cet écart mérite d’être étudié que l’explicabilité prend toute son ampleur, typiquement pour corriger une faille ou découvrir une nouveauté.

Certains systèmes, dont les plus modernes, permettent de mettre en évidence les éléments qui ont joué un rôle dans la décision finale du système. C’est cette compétence qui en font de bons candidats pour les futurs travaux cherchant à renforcer la confiance que l’on pourra accorder aux machines à l’avenir.

Piste 3 : la reproductibilité des résultats

D’autres travaux, plutôt que de chercher des explications dans le détail des traitements, s’attachent à mettre au point des systèmes alternatifs qui produisent des résultats suffisamment similaires aux “vrais” systèmes.

Concrètement, si un système expert affiche des résultats semblables à celui d’un système par apprentissage, on en déduit qu’on dispose d’éléments pour essayer d’expliquer les facteurs déterminants pour la prise de décision.

Cette approche nécessite une charge de travail démultipliée pour obtenir un système qui atteint presque la qualité du premier. Bien qu’elle soit intéressante d’un point de vue expérimental, elle apporte encore peu de réponses sur le terrain opérationnel.

Synthèse

Mais alors, pouvons-nous faire confiance aux décisions prises par l’Intelligence artificielle ? Faut-il forcément faire un choix entre une IA performante et une IA explicable ? Aujourd’hui, c’est une question à laquelle des organismes régulateurs attachent une importance centrale. Ce qui permet de protéger les utilisateurs et plus largement les citoyens puisque l’IA est un outil puissant dans des situations de plus en plus nombreuses dans nos vies (justice, production, sécurité, etc.).

Chez CoperBee, nous prenons le parti de toujours chercher le meilleur compromis entre qualité et explicabilité dans tous nos travaux. Toutes les analyses proposées dans la solution Coper.BI ont été validées par nos spécialistes en IA et NLP, mais également sous l’angle de l’interprétabilité des résultats pour les utilisateurs !

Vous voulez un aperçu de notre approche ? Nous serions ravis de vous faire une démonstration !

Autres articles

Pouvons-nous faire confiance aux décisions prises par l’Intelligence Artificielle ? (3/3)

Deux familles majoritaires d’IA prennent une place imposante dans notre quotidien et soulève la question de la...

Pouvons-nous faire confiance aux décisions prises par l’Intelligence Artificielle ? (2/3)

Comme vous allez le voir, l’IA symbolique satisfait les attentes en matière de confiance pour un système d’IA....